也许人工智能最令人毛骨悚然的方面是它生成深度伪造图像的能力。

当然,有些能带来欢笑。阿诺德·施瓦辛格的脸叠加在克林特·伊斯特伍德的《肮脏的哈利》中,用武器指着逃跑的嫌犯。迈克·泰森变身奥普拉。唐纳德·川普变成了《最好给索尔打电话》的鲍勃·奥登科克尼古拉斯·凯奇在《超人》中饰演路易斯·莱恩。

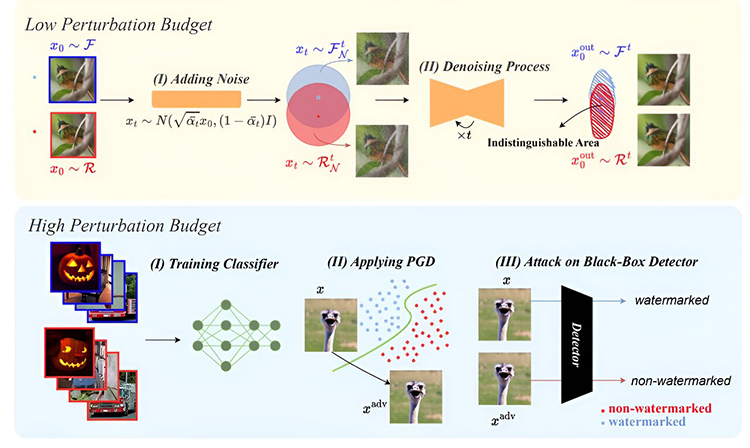

我们对图像水印方法的攻击的说明。上图展示了针对低扰动预算(难以察觉的)水印的扩散净化攻击。它将高斯噪声添加到图像中,创建一个不可区分的区域,从而产生经过认证的水印检测器误差下限。然后使用扩散模型对噪声图像进行去噪。下图描绘了我们的模型针对高扰动预算水印的替代对抗性攻击。我们的攻击包括训练替代分类器,对替代模型进行 PGD 攻击,并使用这些经过处理的图像来欺骗黑盒水印检测器。图片来源:arXiv (2023)。DOI:10.48550/arxiv.2310.00076

但最近的发展预示着一个更令人不安的趋势,因为数字造假变得恶意。

就在上周,演员汤姆·汉克斯在社交媒体上谴责一则利用人工智能生成的肖像来宣传牙齿健康计划的广告。受欢迎的 YouTuber Beast 先生自 2012 年以来其视频观看次数超过 500 亿次,他被错误地显示以 2 美元的价格出售 iPhone 15 Pro。

普通公民也成为目标。人们的面孔在未经同意的情况下出现在社交媒体上的图像中。最令人不安的是“复仇色情”事件的增加,在这些事件中,被抛弃的恋人发布了他们前任的妥协或淫秽姿势的捏造照片。

随着政治分裂的美国谨慎地应对 2024 年总统大选的激烈争议,伪造图像和视频的前景预示着一场前所未有的丑陋选举。

此外,假图像的泛滥颠覆了我们所知的法律体系。正如全国性非营利媒体 NPR 最近报道的那样,律师们正在利用那些有时对真假感到困惑的不幸公众,并越来越多地质疑法庭上提供的证据。

加州大学伯克利分校专门研究数字图像分析的哈尼·法里德(Hany Farid)表示:“这正是我们所担心的,当我们进入这个深度造假的时代时,任何人都可以否认现实。”

他说:“这是典型的骗子红利。”他指的是 2018 年一份关于Deepfake对隐私和民主的潜在攻击的报告中首次使用的术语。

主要数字媒体公司——OpenAI、Alphabet、亚马逊、DeepMind——已承诺开发工具来打击虚假信息。一种关键方法是在人工智能生成的内容上使用水印。

但 9 月 29 日在预印本服务器arXiv上发表的一篇论文提出了关于遏制此类数字滥用的能力的令人不安的消息。

马里兰大学的教授进行了测试,证明保护性水印可以轻松绕过。

“目前我们还没有任何可靠的水印,”该报告《人工智能图像探测器的鲁棒性:基本限制和实际攻击》的作者之一 Soheil Feizi 说。

飞子说他的团队“把它们都打破了”。

“人工智能的误用会带来与错误信息、欺诈甚至选举操纵等国家安全问题相关的潜在危险,”飞子警告说。“深度造假可能会造成人身伤害,从人格诽谤到情绪困扰,影响个人和更广泛的社会。因此,识别人工智能生成的内容......成为一个需要解决的关键挑战。”

该团队使用了一种称为扩散净化的过程,该过程将高斯噪声应用于水印,然后将其删除。它会留下扭曲的水印,可以绕过检测算法。图像的其余部分仅进行了最小程度的更改。

他们进一步成功地证明,能够使用黑盒水印算法的不良行为者可以在假照片上添加标记,欺骗检测器相信它们是合法的。

更好的算法肯定会出现。与病毒攻击的情况一样,坏人总是会努力打破好人提出的任何防御,猫捉老鼠的游戏将继续下去。

但非子却表达了一些乐观的态度。

“根据我们的结果,设计强大的水印是一项具有挑战性的任务,但不一定是不可能的,”他说。

目前,人们在查看包含对他们可能重要的内容的图像时必须进行尽职调查。保持警惕、仔细检查消息来源和充分的常识是必要条件。

更多信息:Mehrdad Saberi 等人,AI 图像检测器的鲁棒性:基本限制和实际攻击,arXiv(2023)。